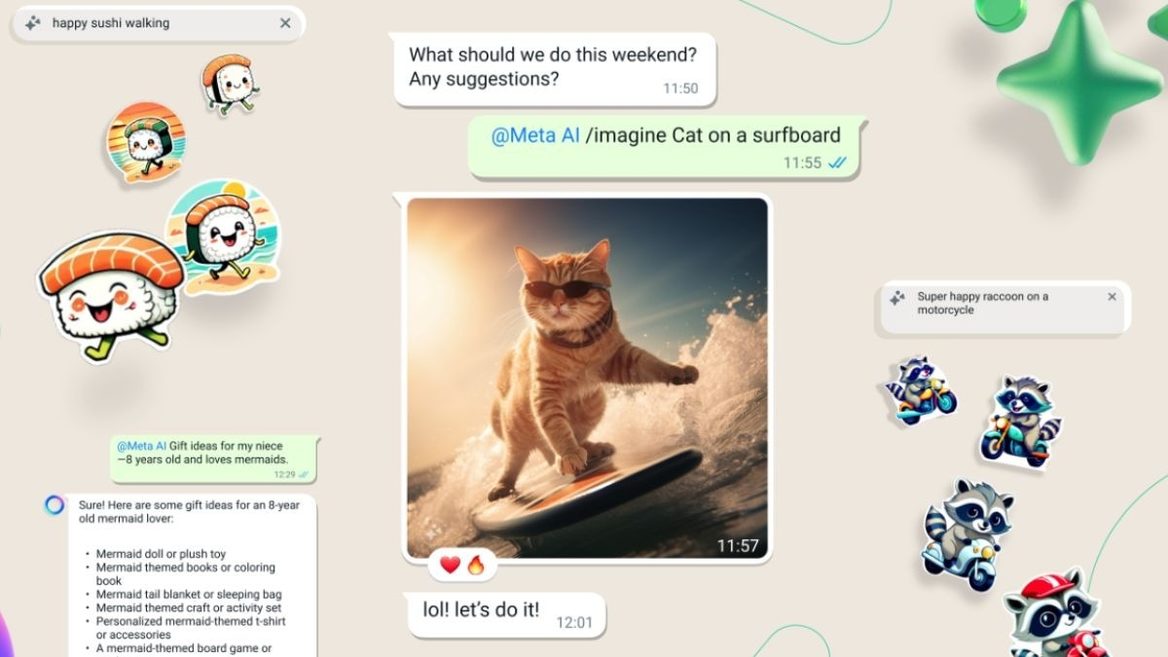

Stable Diffusion показала ИИ-генератор видео по картинке или тексту

Компания представила генеративную модель Stable Video Diffusion, предназначенную для создания видеороликов по текстовому описанию.

Компания представила генеративную модель Stable Video Diffusion, предназначенную для создания видеороликов по текстовому описанию.

Компания представила генеративную модель Stable Video Diffusion, предназначенную для создания видеороликов по текстовому описанию.

Stable Video Diffusion выпущена в виде двух моделей преобразования изображений в видео. Первая генерирует по одному изображению размером 576×1024 пикселей 14 кадров, вторая — 25 кадров. Из них можно сделать видео с частотой кадров от 3 до 30 в секунду. Пока модель не предназначена для создания полнофункциональных или коммерческих приложений.

В основу сервиса легла модель Stable Diffusion, которая генерирует статические изображения на основе текстовых запросов. Исходный код разработчик опубликовал на GitHub, необходимые для локального запуска веса доступны для скачивания на Hugging Face. Также компания выложила исследовательский материал, в котором изложила технические возможности модели.

Модель адаптируется для различных задач: например, ее можно настроить для генерации видео по одному изображению в качестве образца. Stable Video Diffusion станет базовой платформой для семейства производных моделей, которые будут выходить позднее. Компания планирует построить целую экосистему сервисов.

В будущем разработчики представят возможность генерировать видео по текстовому описанию в веб-интерфейсе. Пользователям нужно оформить заявку на включение в список ожидания.

Релоцировались? Теперь вы можете комментировать без верификации аккаунта.