Британский ИИ-гигант DeepMind близок к тому, чтобы научить роботов самостоятельно исследовать окружающий мир, пишет The Next Web.

Пока что искусственный интеллект способен только анализировать получаемые от исследователей данные, но это лишь малая часть бесконечного количества информации, которую роботам предстоит освоить в реальном мире.

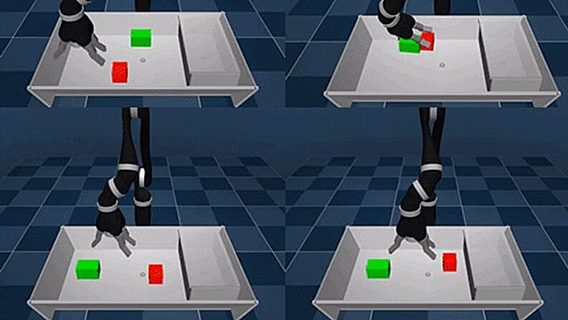

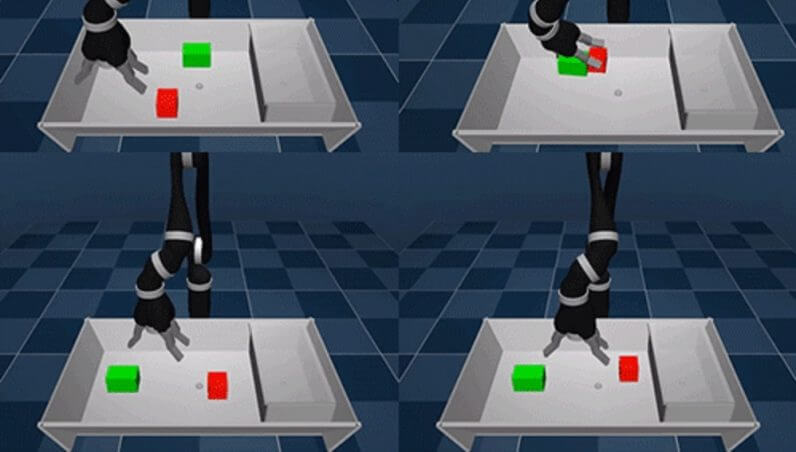

Для решения этой проблемы специалисты DeepMind разработали новую парадигму обучения искусственного интеллекта Scheduled Auxiliary Control. Она основана на поощрении робота за выполнение несложных задач— например, уборки.

«Все вспомогательные задания основаны на одном принципе: они мотивируют агента познавать окружающее пространство. Скажем, активировать тактильные датчики на пальцах, ощущать силу в руках, своё положение в пространстве или передвигать объекты в поле видимости визуальных датчиков», — сообщает компания в своём блоге.

Исследователи не дают роботу инструкции, а встраивают определённые сенсоры (изначально неактивные) и позволяют роботу действовать самостоятельно. Устройство активирует нужные датчики, изучает окружающую среду и при успешном выполнении задания получает баллы.

На первый взгляд может показаться, что в роботе, который пытается что-то нащупать в коробке, нет ничего выдающегося. Однако разработки DeepMind отличает то, что они не запрограммированы, а действуют спонтанно.

Пока компания учит роботов самостоятельно играть с кубикам, но вскоре они смогут показать свою полезность — к примеру, застилать кровать, выносить мусор или кипятить чайник. На сегодняшний день эти задачи неподъёмны для искусственного интеллекта.

Релоцировались? Теперь вы можете комментировать без верификации аккаунта.